2023. 1. 2. 23:37ㆍ학부 강의/AI 입문

1. RNN

가. 순차 데이터 (data sequence)

데이터 간 상호 순서상 연관성을 갖는 경우.

- 시계열 데이터 : 주가 변동, 환율 변동, 모션

- 시계열 신호 또는 이미지 : 음성신호, 동영상 프레임

- 구두 연설, 문서 텍스트

나. RNN의 기능

순차 데이터 처리의 종류

- 예측 : 주가 예측, 문장에서 다음 단어 예측, 동영상에서 다음 프레임 예측 등

- 분류/판단 : 문장 요약, 문법오류판단 등

- 생성 : 번역, 캡션생성(장면 묘사) 등

위와 같은 처리를 위해서는 과거의 상태(과거의 입력)를 기억할 필요가 있음.

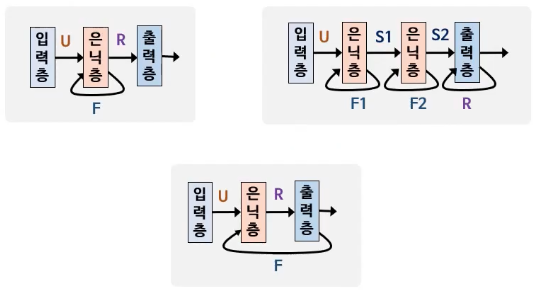

다. RNN의 구조

RNN은 이전 상태를 저장할 수 있는 기능을 가진다.

위와 같이 표현하는 방법을 ‘시간 펼침 (Unrolling in time)’이라고 한다.

RNN 분석 및 학습을 편리하게 할 수 있다.

RNN의 시간 펼침의 결과는 보기에 FNN 형태가 된다.

라. 대표적인 RNN 모델

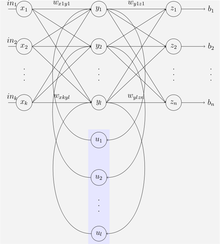

(1) SRN (Simple Recurrent Network)

단순 순환망.

3 계층 구성.

Elman Network으로도 불림.

구조가 간단하고 많이 사용된다.

이미지 출처 : https://ko.wikipedia.org/wiki/순환_신경망

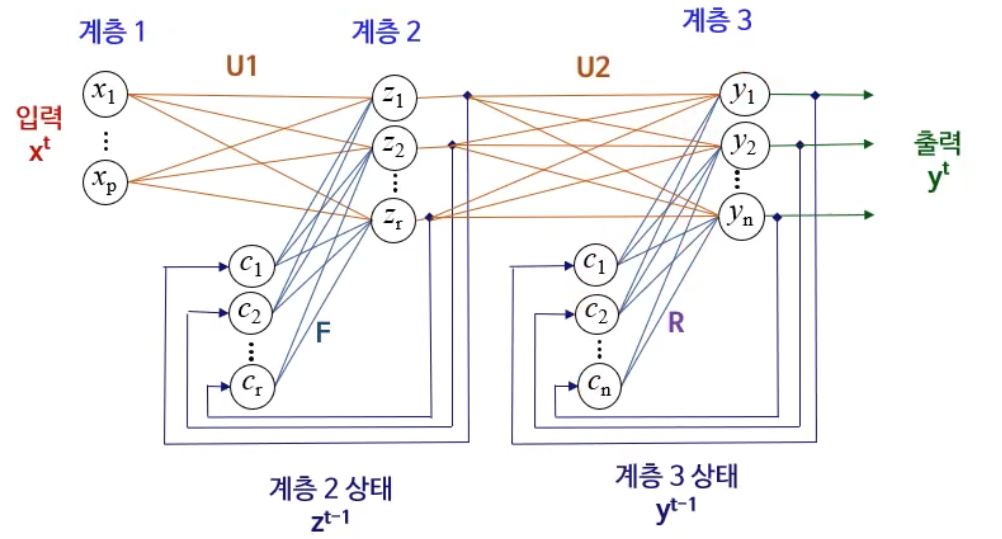

(2) RMLP (Recurrent MLP)

다계층 구성.

2. LSTM

장단기 메모리(Long Short-Term Memory, LSTM)는 순환 신경망(RNN) 기법의 하나.

LSTM 노드는 일반 RNN에서 은닉층 노드를 대체.

셀, 입력 게이트, 출력 게이트, 망각 게이트를 이용해 기존 순환 신경망(RNN)의 문제인 기울기 소멸 문제(vanishing gradient problem)를 해결하기 위해서 개발되었다.

출처 : https://ko.wikipedia.org/wiki/장단기_메모리

가. LSTM 노드의 구조와 기능

LSTM 노드는 3개의 게이트, 하나의 메모리 셀, 후보상태생성기로 구성된다.

- 게이트 : 주어진 신호의 양을 조절. 시그모이드 활성화 함수를 사용하는 일반 뉴런.

- input gate : 후보 상태를 얼마나 반영할지

- forget gate : 이전 상태의 값을 얼마나 반영할지

- output gate : 출력의 크기를 조절

- 메모리 셀 : 상태를저장하는 기능

- 후보상태생성기 : 상태 생성에 사용할 후보상태를 산출

나. GRU

Gated Recurrent Unit.

Update gate(Forget + Input의 역할), Reset gate 2개의 게이트로 구성된다.

LSTM에 비해 더 적은 수의 매개변수를 가짐.

연산량이 감소했지만 다성음악 학습이나 음성 인식 분야에서 LSTM과 유사한 성능을 가진다.

출처 : https://ko.wikipedia.org/wiki/순환_신경망

'학부 강의 > AI 입문' 카테고리의 다른 글

| 2023-01-04 AI입문12 (0) | 2023.01.04 |

|---|---|

| 2023-01-04 AI입문_11 (0) | 2023.01.04 |

| 2022-11-13 AI입문_9 (0) | 2022.11.13 |

| 2022-11-07 AI입문_8 (0) | 2022.11.08 |

| 2022-11-05 AI입문_7 (0) | 2022.11.06 |